こんにちは、たねやつです。

こんにちは、たねやつです。

前回の記事では、LM Studioをインストールして、基本的なチャットを試すところまでを紹介しました。 今回は一歩進んで、様々なLLMモデルを試すための設定方法や、ダウンロードしたモデルを効率的に管理する方法について詳しく解説していきます。 モデルの特性を理解し、設定を調整することで、AIの応答を自分好みにカスタマイズできます!

前の記事

この記事でできること

- おすすめのLLMモデルがわかる

- モデルごとの詳細な設定項目を理解できる

- 複数のモデルを効率的に管理する方法がわかる

おすすめモデルの紹介

LM Studioの魅力は、世界中の開発者が公開している多種多様なモデルを簡単に試せる点にあります。 前回は、比較的新しく高性能なモデルとして「gpt-oss」を紹介しました。

もちろん、gpt-oss以外にも優れたモデルはたくさんあります。ここでは、特定の用途に特化したおすすめのモデルをいくつか紹介します。画面上部のモデル名を選択するドロップボックスに適当なモデル名を入れるとダウンロード候補を検索することができます。

日本語の会話が得意なモデル

qwen/qwen3-8b- Alibaba Cloudが開発したQwenシリーズのモデル。比較的小規模ながら、日本語の対話能力が高いと評判です。gpt-ossよりも小規模なため、比較的動作させやすいのも魅力です。

コーディング特化モデル

Qwen/Qwen2.5-Coder-7B-Instruct- 同じくQwenシリーズの、コーディングに特化したモデルです。コードの生成や補完、デバッグなどで高い性能を発揮します。

これらのモデルも、LM Studioの検索画面から探してダウンロードできます。

前回ダウンロードしたgpt-ossと応答を比較してみるのも面白いでしょう。ぜひ試してみてください。

モデル設定を理解する

チャット画面の右側には、モデルの挙動を細かく制御するための設定パネルがあります。これらのパラメータを調整することで、AIの応答を大きく変えることができます。

Inference Parameters(推論パラメータ)

Temperature(温度)- 応答の「ランダム性」や「創造性」を調整します。値が高いほど(例: 1.0)、より多様でクリエイティブな文章を生成しますが、脱線しやすくもなります。値が低いほど(例: 0.1)、より決定的で一貫性のある応答になります。

Top P(トップP)- 生成される単語の選択肢を確率の高いものに絞り込むためのパラメータです。

Temperatureと同様に応答の多様性を制御しますが、より高度な方法です。一般的にはTemperatureかTop Pのどちらか一方を調整します。

- 生成される単語の選択肢を確率の高いものに絞り込むためのパラメータです。

Context Length (n_ctx)(コンテキスト長)- モデルが記憶できる会話の長さを決めます。この値が大きいほど、より長い過去のやり取りを覚えておくことができますが、メモリ(VRAM)の使用量も増加します。

モデルの管理

たくさんのモデルをダウンロードすると、どれがどれだか分からなくなったり、ストレージを圧迫したりします。LM Studioには、モデルを管理するための専用画面が用意されています。

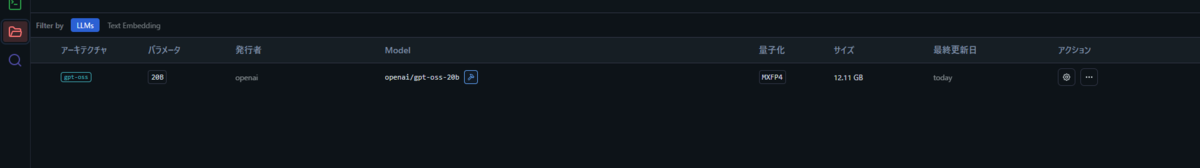

- 画面左のメニューから、フォルダアイコン(My Models)をクリックします。

- ダウンロード済みのモデルが一覧で表示されます。

この画面では、各モデルのファイルサイズや保存場所を確認できます。 不要になったモデルは、モデル名の右側にある点々ボタン内のゴミ箱アイコンをクリックすることで、PCから完全に削除できます。

最後に

今回は、LM StudioでAIの性能を最大限に引き出すためのモデル設定と管理方法について解説しました。 パラメータを少し変えるだけで、AIの性格がガラッと変わるのが面白いところです。ぜひ色々なモデルと設定を試して、自分だけのAIアシスタントを育ててみてください。

次回は、LM Studioの目玉機能の一つである「ローカルAPIサーバー」の使い方を紹介します。